Zo leert Google computers menselijke beweging herkennen

Nieuwe Google-software herkent menselijke bewegingen in video's, waardoor computers de volgende handelingen van mensen beter zouden voorspellen.

De afgelopen jaren zijn algoritmes steeds beter geworden in het vinden en herkennen van objecten op afbeeldingen, maar het interpreteren van menselijke beweging blijft volgens onderzoekers van Google 'een grote uitdaging'. Bewegingen verschillen meer dan objecten, waardoor het moeilijk is om er labels op de plakken.

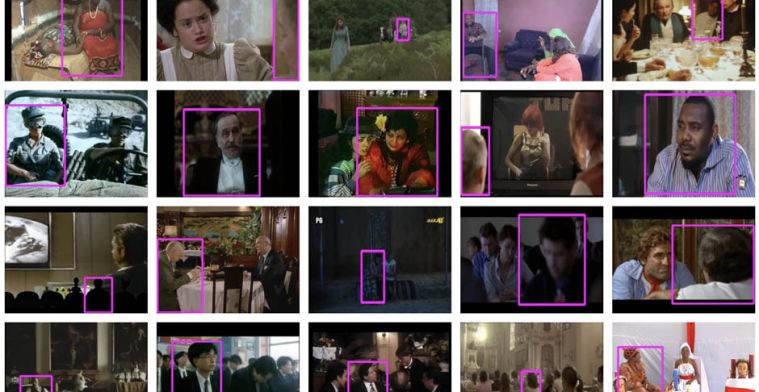

Google heeft een nieuwe manier gepresenteerd om de ontwikkeling van computervisie rondom menselijke beweging naar een hoger niveau te tillen. Dat noemt het bedrijf 'atomic visual actions', afgekort 'AVA'. Deze technologie gebruikt openbare YouTube-url's die gelabeld zijn met 80 verschillende fysieke acties, zoals lopen, kussen of drinken. In totaal worden er bijna 58 duizend filmpjes van drie seconden gebruikt om de computer te 'voeren'.

Google geeft iedereen toegang tot de dataset via deze website. Daarop kun je bekijken hoe het algoritme bewegingen heeft gelabeld. Uiteindelijk moet AVA helpen om het herkennen van menselijke beweging te verbeteren en te voorspellen wat een persoon vervolgens gaat doen.

Bright Day, het techfest van Nederland

Ons techfest Bright Day is op 18 en 19 november in de Jaarbeurs in Utrecht. Ruim 20 duizend vierkante meter met gadgets, games en nieuwe technologie. En als hoofdsprekers de bekende YouTubers Casey Neistat en Simone Giertz. Kijk hier voor het programma en tickets.

Like Bright op Facebook voor meer updates over Bright Day